지난 글에서는 "AI 에이전트"가 어떻게 자율성과 유연성을 기반으로 우리 업무에 스며들고 있는지를 살펴보았습니다. 단순한 자동화를 넘어, 스스로 판단하고 실행하는 '지능형 시스템'으로서의 AI가 어떻게 현실이 되고 있는지를 확인하셨을 거예요.

그렇다면 이제는, 그 AI 에이전트들이 실제로 어디에서, 어떻게 작동하고 있을까요?

우리가 매일처럼 사용하는 클라우드. 그 방대한 AI가 돌아가는 공간은 어디에 있을까요?

이 모든 AI 시스템이 돌아가는 물리적 기반, 그 실체는 무엇일까요?

[2025 Microsoft Cloud & AI Bootcamp] 네 번째,

“데이터센터 이야기 – 클라우드의 물리적 기반을 들여다보다”라는 주제를 통해,

AI와 클라우드 서비스가 작동하는 무대 뒤편,

Microsoft의 글로벌 데이터 센터 인프라를 함께 들여다보려 합니다.

📌

- 주제: 데이터센터 이야기 – 클라우드의 물리적 기반을 들여다보다

- 일시: 2025년 7월 23일 수요일 오후 12:15 ~ 13:00

- 장소: 온라인

- 발표자: Alistair Speirs ( 인프라 마케팅 시니어 실장, Microsoft )

🔗해당 세션 다시보기 링크🔗: AZBC: 데이터센터 이야기 – 클라우드의 물리적 기반을 들여다보다

🔗모든 세션 다시보기 링크🔗: Microsoft Cloud and AI Bootcamp

[ Global Infrastructure Overview ]

🌍 전 세계 70개 이상의 Azure 리전

Microsoft는 현재 전 세계 70개 이상의 Azure 리전을 운영하고 있으며, 이는 어떤 클라우드 제공 업체보다 많은 수입니다.

데이터 센터는 한두 개의 서버룸이 아니라, 실제 수천 평 규모의 하이퍼스케일 인프라입니다.

- 미국 워싱턴 퀸시의 US West 2 리전 → 캠퍼스처럼 여러 건물이 모여 하나의 리전을 구성

- 미국 동부의 US East 리전 → 끊임없는 증설 진행 중

- 싱가포르 → 공간 제약으로 인해 수직적 구조의 다층 데이터센터 설계

🧠 AI에 최적화된 인프라 구조

Microsoft는 전통적인 컴퓨팅을 넘어서, AI의 요구를 충족시키는 엔드 투 엔드 최적화를 실현하고 있습니다.

- 서버, 네트워크, 실리콘, 에너지까지 모든 계층에서 혁신

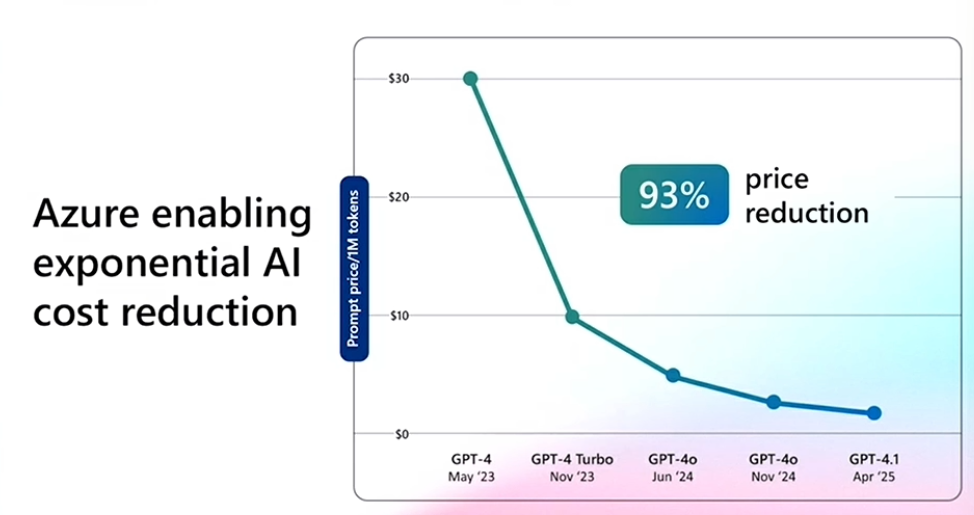

- GPT-4 같은 AI 모델의 가격이 93%까지 하락한 이유도 여기에 있음

- AI를 위해 필요한 막대한 연산력과 저장 공간을 모두 데이터센터가 제공

⚡전력과 지속가능성

- 전 세계 전기의 약 1%가 데이터 센터에서 사용

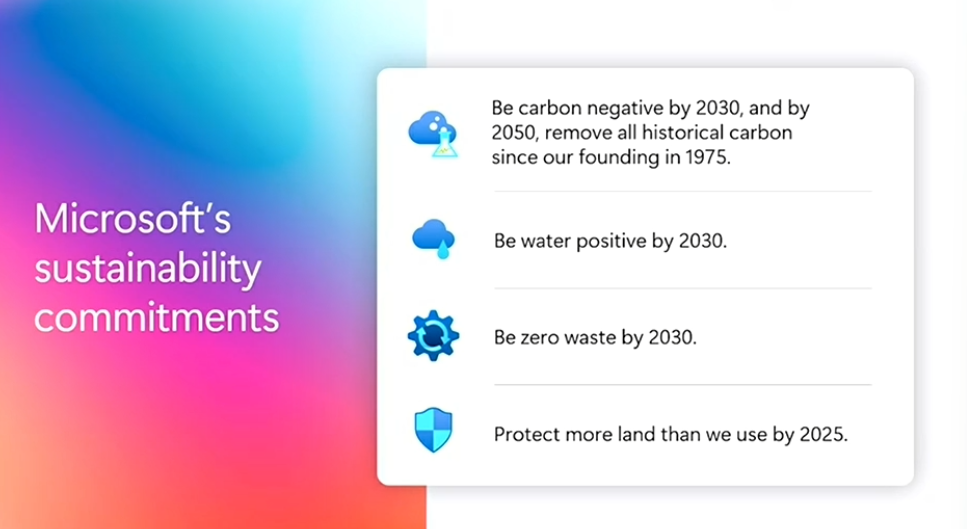

- Microsoft는 34GW 이상의 재생에너지 확보 → 2025년까지 100% 탄소 제로 달성 목표

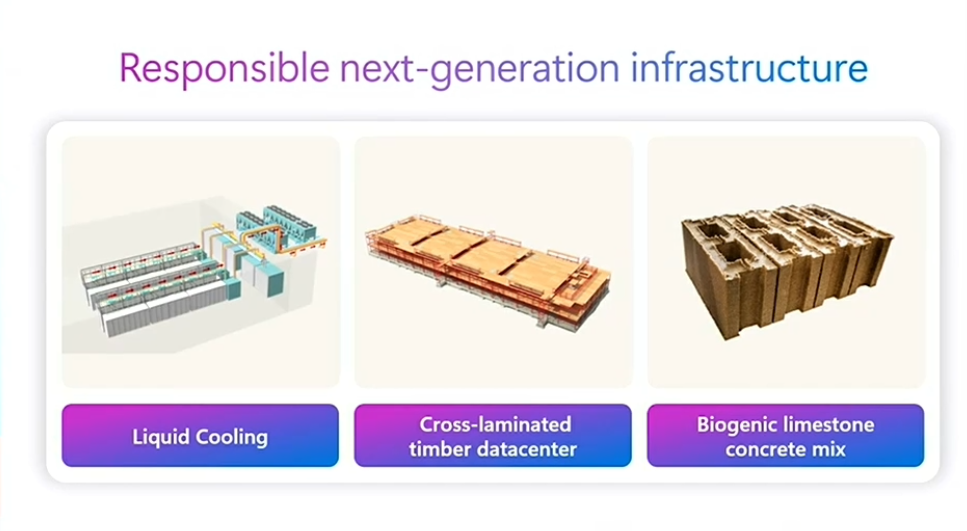

- 액체 냉각 기술을 사용해 증발식 냉각 없이 열 방출

- 교차 적층 목재, 바이오 콘크리트 등 건축자재까지 친환경 전환

[ Our AI Infrastructure ]

이번에는 Microsoft가 어떻게 AI 인프라를 위한 하드웨어 스택 전체를 설계하고 최적화하고 있는지 살펴봅시다.

🔩 Maia 100

- Maia 100은 Microsoft가 자체 설계한 첫 AI 가속기

- 높은 성능과 동시에 초고효율 전력 설계

- 단순한 칩이 아니라, 칩 + 서버 + *랙 + 냉각 시스템이 통합된 완성형 AI 시스템

- Sidekick → 맞춤형 냉각 장치

→ 기존 공랭식 데이터 센터에 추가로 구축 가능

→ 공간 낭비 없이 서버 확장 + 무수(無水) 운영 가능

*랙(Rack)

- 데이터센터에서 서버나 장비를 안전하고 효율적으로 정리·설치하는 표준 장치 보관함

- 서버의 집이자, 냉각·전원·네트워크가 모두 연결되는 중심 단위

🔩 Grace Blackwell

- NVIDIA의 최신 AI 시스템

- *Grace ARM CPU + *Blackwell GPU

- Microsoft Azure는 세계 최초로 해당 GB200 칩 기반의 서버, 랙, 전체 데이터센터를 가동

- 이미 OpenAI 등 실전 워크로드에서 사용 중

*Grace ARM CPU

- NVIDIA가 만든 서버용 ARM 기반 CPU

- 낮은 전력 소모 + 고성능 → AI와 HPC 워크로드에 최적화

*Blackwell GPU

- NVIDIA의 최신 AI 연산 전용 GPU 아키텍처

- GPT-4 수준의 대규모 모델 훈련·추론에 탁원

- 메모리 대역폭↑, 연산 효율↑ → 초거대 모델에 최적화

*ARM

- 저전력, 고효율에 최적화된 CPU 아키텍처

✨ Azure는 이 인프라 전반에 걸쳐 고성능 *엑사바이트 스토리지를 구축하고 있습니다.

- 초당 200만건 이상의 I/O 트랜잭션을 처리하는 *Blob Storage 인프라 구축

- 수백만 개의 Blob Storage 계정을 구성해, GPU 학습을 위한 대규모 병렬 데이터 처리 가능

→ 온프레미스 시스템으로는 불가능한 슈퍼컴퓨터급 성능 실현

*엑사바이트(EB) 스케일

- 1 EB = 1,000 PB = 1,000,000 TB

- 영화 파일로 환산하면 HD 영화 약 2억 편 분량 저장 가능

*Blob Storage

- Binary Large Object의 약자

- 이미지, 비디오, CSV, 로그 파일 등 비정형 데이터 저장에 최적화된 Azure 스토리지

- 확장성 + 저비용 + 안정성이 특징

🌐 InfiniBand 네트워크

- Azure는 GPU 랙 전체에 *InfiniBand 네트워크를 배포

- 일반 고속 네트워크 대비 4배 *대역폭

- 대규모 AI 모델 학습시 병목 최소화 → 처리 속도 대폭 향상

*InfiniBand 네트워크

- 고속, 저지연, 고대역폭을 제공하는 데이터센터용 네트워크 기술

(최대 수백 Gbps 속도로 서버와 서버, 서버와 스토리지 연결)

(매우 짧은 지연 시간 → 실시간 연산/병렬 작업에 적합)

- 주로 고성능 컴퓨팅(HPC), AI 학습, 클러스터 연결에 사용

*대역폭

- 한 번에 보낼 수 있는 데이터의 양

- 클수록 데이터 전송 속도가 빠름

🧩 Azure Boost

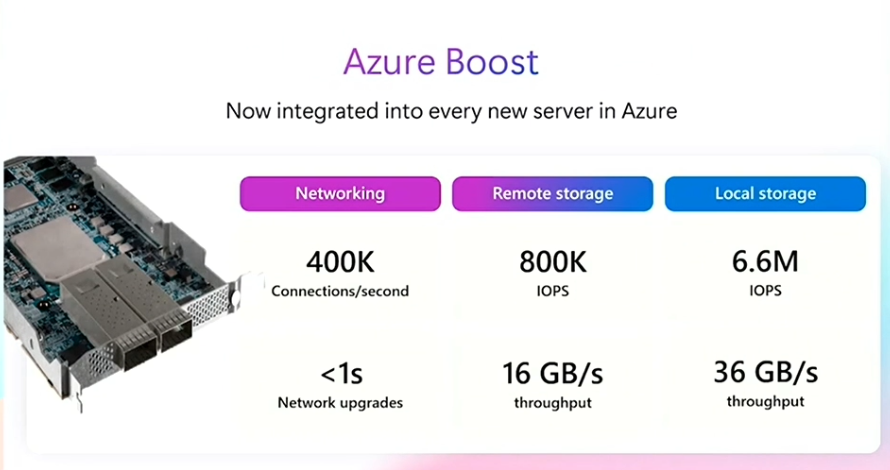

- Azure 서버에는 기본적으로 Azure Boost 칩 내장

→ 초당 40만 개 이상 네트워크 연결

→ 660만 *IOPS(로컬), 80만 IOPS(원격) 처리

- AI 뿐 아니라 모든 VM(Virtual Machine) 에서 기본 제공

*IOPS

- Input/Output Operations Per Second

- 초당 입출력 처리 건수

- 숫자가 높을수록 더 많은 요청을 빠르게 처리 가능

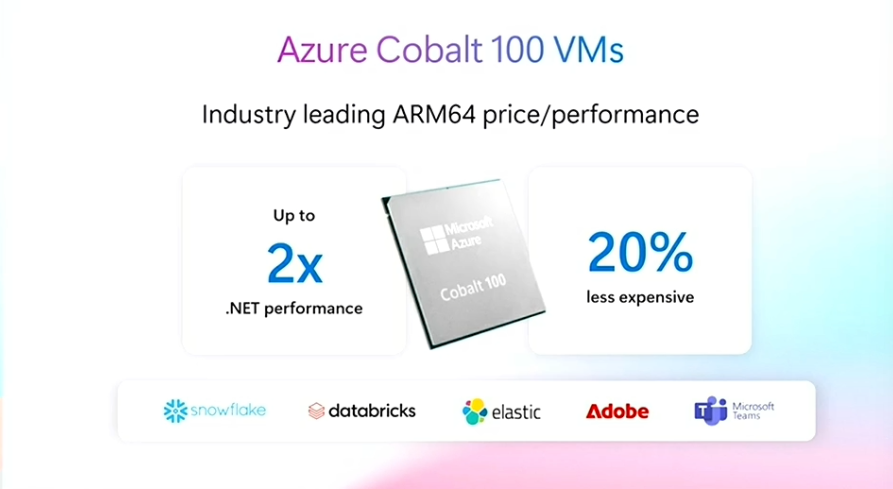

🧩 Azure Cobalt

- .NET 워크로드 기준 2배 성능 향상, 20% 비용 절감

- Databricks, Snowflake, Microsoft Teams 등 다양한 서비스가 이미 채택

🔍 하드웨어의 다양성

- x86/x64

- *CISC 아키텍처 기반

- 높은 하위 호환성

- 과거 40년간의 소프트웨어 자산들을 그대로 클라우드로 이전 가능 - ARM

- *RISC 아키텍처 기반

- 전력 효율에 최적화

- 초기엔 모바일 기기에 사용, 이제는 클라우드 네이티브 데이터센터 워크로드에도 활용

- 64비트 ARM 기반 CPU → Azure Cobalt 100 출시

→ Cobalt 100 기반의 VM: ARM VM에 비해 가격 대비 성능 ↑

: 클라우드 네이티브, Linux 기반 워크로드에 강점 - HPC

- 고대역폭 메모리와 고속 네트워크 필수 - AI

- GPU 또는 *ASIC 기반 가속기 활용

- 수만 개의 코어를 병렬로 처리 → AI 학습/추론 속도 향상 - Quantum

- Quantum Processing Unit (QPU)

- 0과 1이 동시에 존재할 수 있는 양자비트(큐비트) 사용

- 고전 컴퓨팅으로 수천 년 걸릴 문제도 몇 초 내 해결 가능

- 모든 워크로드에 적합하지는 않음

*CISC / RISC / ASIC

1. CISC (Complex Instruction Set Computing)

- 복잡한 명령어 한 번에 처리

2. RISC (Reduced Instruction Set Computing)

- 단순 명령어로 빠르고 효율적

3. ASIC (Application-Specific Integrated Circuit)

- 특정 작업 전용으로 설계된 맞춤형 칩

[ New cloud regions in Asia Pacific ]

🏗️ APAC 지역 신규 리전 개설 현황

- 신규 데이터센터 오픈

: 뉴질랜드 오클랜드, 인도네시아 자카르타, 말레이시아 쿠알라룸푸르

- 기존 리전 확장

: 대만 전역, 일본 오사카, 서호주 퍼스 (확장 존 개설)

💡Microsoft는 리전(region) 구축 시 서로 다른 위치에 위치한 3개의 데이터센터를 짓습니다.

해당 세 곳을 가용성 영역(Availability Zones) 이라고 부릅니다.

→ 서로 약 50km 이상 떨어져 있어 자연재해나 장애 발생 시 리스크 분산

→ 전력, 냉각, 네트워크를 이중화하여 고가용성 확보

→ Zonal Configuration으로 설정 시, 서비스가 자동 분산되어 동작

▷ 각 가용성 영역에 새로운 DC를 추가하면 리전 자체를 계속 확장 가능

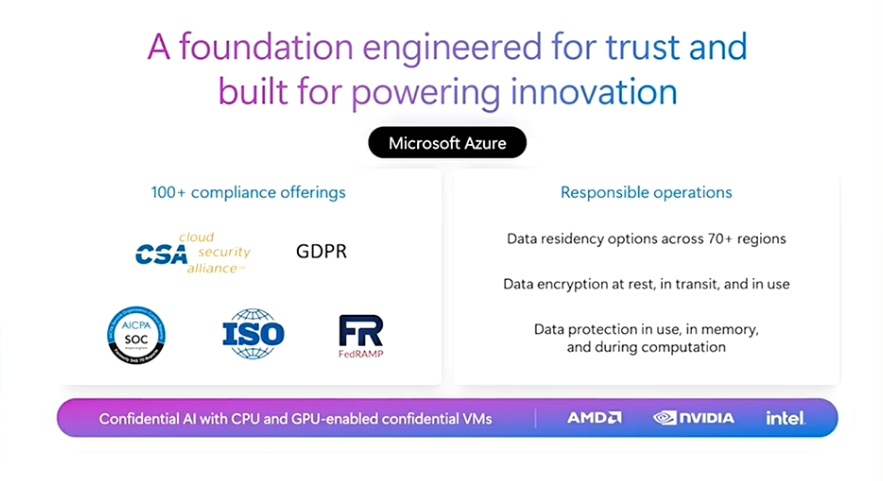

🔐 데이터 거버넌스와 신뢰 기반 운영

글로벌 확장은 단순한 물리적 인프라만으로는 불가능합니다.

Microsoft는 다음과 같은 신뢰 기반 구조를 통해 각국의 규제와 고객 요구를 모두 만족시키고 있습니다.

- *ISO, *GDPR 등 글로벌 100개 이상의 컴플라이언스 규격 충족

- 사용자 데이터가 해당 국가에 안전하게 저장

- Microsoft Cloud for Sovereignty 제공 → 사용자 키로 암호화된 데이터 보안 보장

- Confidential compute → 클라우드 운영자 접근도 원천 차단

*ISO (국제표준화기구)

- 국제적으로 통용되는 정보 보안 및 품질관리 기준

- 주요 클라우드 기업들은 신뢰성, 보안성, 운영 체계를 증명하기 위해 이 인증을 획득

*GDPR (General Data Protection Regulation)

- 유럽연합(EU)의 개인정보 보호법 – 세계에서 가장 강력한 개인정보 보호 규정

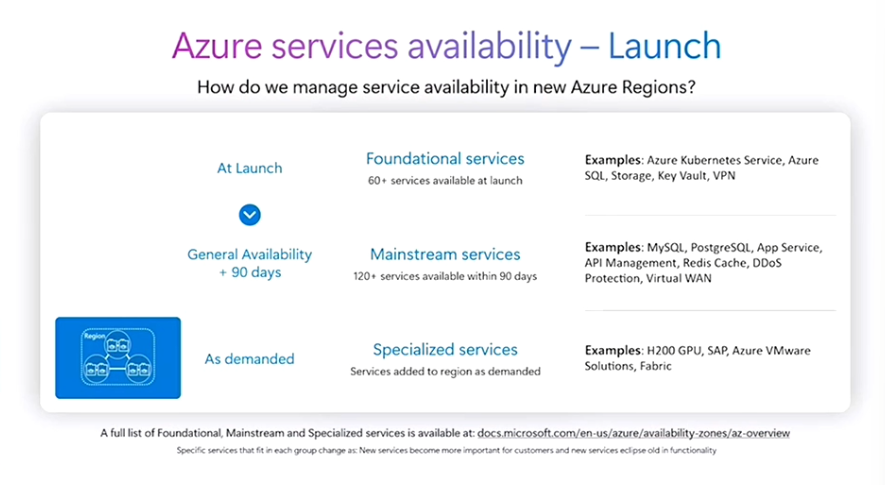

🔗 새로운 데이터 센터 리전, 처음부터 모든 Azure 서비스를 쓸 수 있을까?

- Microsoft는 모든 리전을 일관된 방식으로 구축하며, 다음과 같이 단계적으로 서비스가 제공됩니다.

1️⃣ 기본 서비스 (Foundational Services)

- 가상 머신(VM), 스토리지, 네트워킹, Azure Kubernetes, SQL 서버. Key Vault 등

→ 리전 오픈 시 바로 제공

2️⃣ 주요 서비스 (Mainstream Services)

- 90일 이내에 추가되는 일반 서비스

- App Service, Redis Cache, MySQL, PostgreSQL, 가상 WAN, DDoS 보호 기능 등

3️⃣ 특수 서비스 (Specialized Services)

- 수요에 따라 배포되는 특수화된 서비스

- AI 서비스처럼 특정 하드웨어가 필요한 경우, 해당 리전을 특수화 리전(specialized region)이라고 부르기도 함

- (예시) 인도네시아 센트럴 리전은 이미 전 포트폴리오 지원 가능

✨ Microsoft 365 클라우드 포트폴리오 또한 지원!

- Microsoft Teams, Microsoft 365, Copilot 등 모든 업무 도구

- 고급 데이터 거주지 기능 제공

→ 특정 국가 또는 리전에만 데이터 저장을 제한하도록 지정 가능

👀 데이터센터 내부, 함께 보실까요?

직접 들어갈 수는 없지만, Microsoft는 가상 투어를 통해 데이터센터 내부 모습을 공개하고 있습니다.

- 링크🔗: aka.ms/dctour

- Hot/Cold Aisle 구조, 스토리지 블레이드, 컴퓨트 서버 블레이드 등

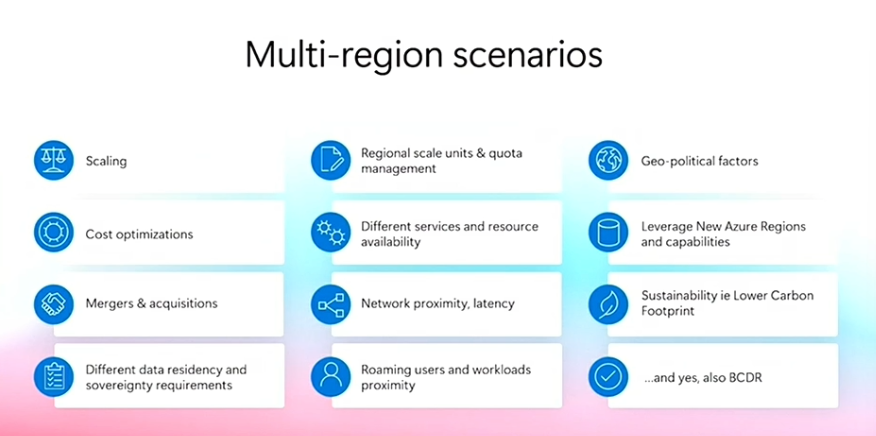

[ Multi-region strategy ]

지금까지 우리는 단일 데이터 센터와 단일 리전을 살펴봤지만,

클라우드의 핵심은 전 세계의 분산된 전체 글로벌 클라우드 역량을 활용하는 데 있으며,

이를 '멀티 리전 전략(Multi-region strategy)'이라고 부릅니다.

멀티 리전 전략은 전 세계 다양한 지역에 서비스를 분산 배포함으로써 비즈니스 민첩성, 고가용성, 복원력, 비용 절감을 가능하게 합니다. 이를 통해 재해나 지역 이슈 발생 시에도 서비스 지속성과 성능을 유지할 수 있습니다.

💡 멀티 리전 전략의 핵심 가치

1️⃣ 복원력 (Resilience)

- 여러 리전에서 비즈니스 핵심 워크로드를 운영할 경우,

더 높은 SLA(서비스 수준 계약) 확보 가능

- 공급망 문제, 에너지 부족 등 이슈 대응 유연성 확보

2️⃣ 성능 (Performance)

- 사용자와 가장 가까운 리전에서 서비스 제공

→ 지연 시간 감소

3️⃣ 민첩성 및 유연성 (Agility and Flexibility)

- 새로운 리전 개설 시 최신 서비스에 가장 먼저 접근 가능

- 클라우드 인프라의 진화에 맞춰 서비스 구성도 유연하게 확장 가능

멀티 리전 전략은 운영 확장, 고객의 데이터 거주지 요건 충족 등 다양한 시나리오에서 유용합니다.

따라서 비즈니스 요구사항, 지역적 규제 또는 지속 가능성 목표까지 고려하여 솔루션을 맞춤 설계하는 것이 중요합니다.

멀티리전은 단순히 인프라 분산이 아닌 클라우드 아키텍처의 전략적 의사결정입니다.

'계획 → 최적화 → 확장' 이라는 주요 단계를 기반으로, Azure의 리소스와 가이드를 적극 활용하는 것이 중요합니다.

이번 시리즈에서는 Microsoft의 데이터센터부터 AI 인프라, 그리고 글로벌 전략까지 함께 살펴보았습니다.

이제 여러분의 클라우드 설계에도 AI + 인프라 + 전략적 아키텍처라는 3박자가 함께하길 바랍니다.

여러분의 인텔리전트 여정, 언제나 데이터스랩과 함께해요! 😊

다음 주제는 자율형 AI 시대의 개발 패러다임 – 새로운 ‘Agentic Development’의 세계 입니다!

다음 글에서 뵙겠습니다!

감사합니다. 뿅 ㅇ_<☆

※ 본 글은 Microsoft Cloud & AI Bootcamp 세션을 기반으로 작성되었으며, 정리 과정에서 OpenAI ChatGPT를 활용하여 작성하였습니다.