[2025 Microsoft Cloud & AI Bootcamp] 시리즈의 마지막 여정을 시작합니다!

이번 편에서는 "왜 그리고 어떻게 HPC가 AI의 성장을 가능하게 하는가?"라는 주제로,

AI와 HPC의 관계부터 Azure가 제공하는 하드웨어·소프트웨어 솔루션, 그리고 국내 고객들의 실제 적용 사례까지 풀어보겠습니다.

AI 시대에 HPC는 더 이상 과학 연구나 엔지니어링 시뮬레이션만의 영역이 아닙니다.

초거대 AI 모델 학습, 복잡한 연산 병렬 처리, 초저지연 네트워킹 — 이 모든 요소가 HPC의 핵심이자, AI를 한 단계 도약시킬 엔진입니다.

Azure는 온프레미스 수준의 HPC 환경을 그대로 클라우드로 확장하여, AI와 HPC가 상호 보완적으로 발전할 수 있는 기반을 제공합니다.

그럼, AI와 HPC가 만날 때 어떤 시너지가 발생하는지 함께 살펴보시죠! 🚀

💡 HPC·AI·HBM·IaaS의 연결고리 – 성능과 확장성의 교차점

AI 모델이 초거대화되면서 HBM(High Bandwidth Memory)의 중요성은 기하급수적으로 커지고 있습니다.

HBM은 기존 DRAM 대비 수십~수백 GB/s의 메모리 대역폭을 제공하여,

대규모 행렬 연산과 파라미터 로딩 속도를 획기적으로 높입니다. 이는 곧 GPU·CPU의 실제 연산 효율과 직결됩니다.

아무리 강력한 연산 코어라도, 메모리에서 데이터를 충분히 빠르게 공급받지 못하면 병목이 발생하죠.

따라서 HPC 인프라에서 HBM의 채택과 확장은 CPU/GPU 성능의 상한선을 끌어올리는 핵심 요소가 됩니다.

여기에 HPC(High Performance Computing)는 이런 고속 메모리·GPU·네트워킹 자원을 병렬 처리와 초저지연 통신으로 묶어내는 플랫폼입니다.

HPC는 단순히 하드웨어 집합이 아니라, 대규모 연산을 ‘끊김 없이’ 처리할 수 있도록 설계된 전체 시스템 아키텍처입니다.

AI 훈련 시, HBM이 데이터 공급 속도를 책임진다면, HPC는 이 데이터를 수천 개의 GPU와 CPU에 병렬로 분산·연산하는 ‘조율자’ 역할을 하는 셈입니다.

여기에 IaaS(Infrastructure as a Service) 모델이 결합되면, 이런 HPC 자원을 온디맨드(On-Demand)로 확보·해제할 수 있는 유연성이 생깁니다.

Azure HPC는 IaaS 기반으로 제공되어,

- 필요한 순간에만 고성능 VM, HBM 메모리, InfiniBand 네트워크를 확보하고

- 워크로드 종료 후 자원을 해제하여 비용을 최적화하며

- 온프레미스와 동일한 아키텍처로 코드 수정 없이 이전 가능하게 합니다.

즉, HBM이 ‘속도’를, HPC가 ‘규모’를, IaaS가 ‘유연성’을 책임지는 구조가 만들어집니다.

이 조합은 AI와 HPC가 상호 가속하며 성장하는 오늘날, 클라우드에서만 가능한 혁신적인 인프라 전략이라 할 수 있습니다.

📌

- 주제: 왜 그리고 어떻게 HPC가 AI의 성장을 가능하게 하는가?

- 일시: 2025년 7월 24일 금요일 오전 12:45 ~ 13:30

- 장소: 온라인

- 발표자: 문수영 ( 기술 영업, 한국 Microsoft )

🔗해당 세션 다시보기 링크🔗: AZBC: 왜 그리고 어떻게 HPC가 AI의 성장을 가능하게 하는가?

🔗모든 세션 다시보기 링크🔗: Microsoft Cloud and AI Bootcamp

AI 시대에 HPC(High Performance Computing)는 더 이상 과학 연구나 엔지니어링 시뮬레이션만의 영역이 아닙니다.

수백~수천억 개의 파라미터를 가진 초거대 AI 모델을 학습하고, 복잡한 연산을 병렬로 처리하며,

실시간에 가까운 응답을 내놓기 위해서는 고속 연산·대용량 데이터 처리·저지연 네트워킹이 필수입니다.

이 모든 요소가 바로 HPC 인프라의 핵심이죠.

Azure는 온프레미스 수준의 HPC 환경을 그대로 클라우드로 확장해, AI와 HPC가 상호 보완적으로 발전할 수 있는 기반을 제공합니다.

*온프레미스 (On-Premises)

: 조직이 직접 보유하고 운영하는 서버·네트워크·스토리지 인프라 환경

: 클라우드와 달리 모든 하드웨어·소프트웨어를 자체 데이터센터에 설치하고 관리

🔍 HPC와 AI의 관계 — 경쟁이 아닌 상호의존

AI가 급격히 발전하는 지금, 많은 분들이 "HPC는 AI 시대에 어떤 역할을 할까?"라는 질문을 합니다.

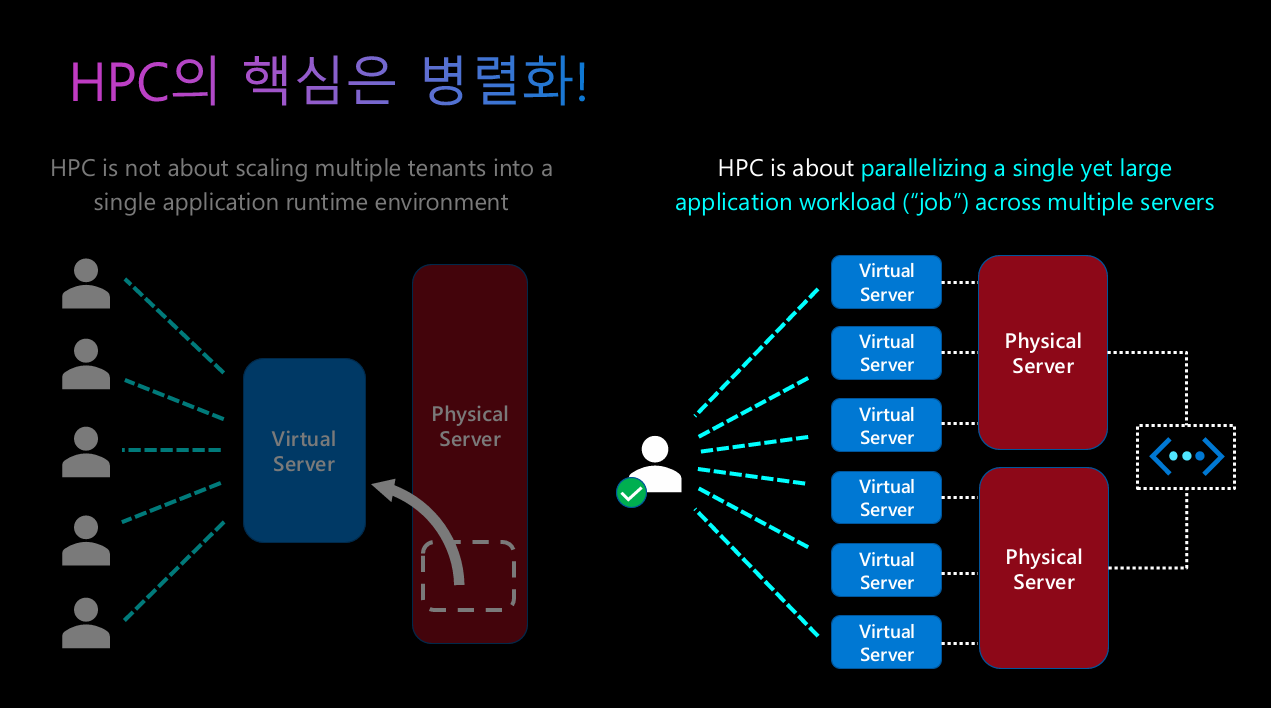

HPC(High Performance Computing)는 본질적으로 복잡하고 대규모의 연산을 병렬로 처리하기 위한 시스템입니다.

이는 세 가지 요소로 구성됩니다.

- 컴퓨팅: 다수의 CPU·GPU를 병렬 연결

- 스토리지: 대규모 데이터 저장·처리

- 네트워크: 노드 간 초고속 데이터 전송

여기에 병렬화(parallelization) 기술이 핵심적으로 적용됩니다.

*노드 (Node)

: 컴퓨팅 네트워크나 클러스터를 구성하는 개별 컴퓨터·서버 단위

: HPC에서는 보통 여러 노드를 연결해 하나의 대규모 연산 환경을 구성하며, 각 노드는 CPU·메모리·스토리지를 가짐

📌 병렬화 방식

- 스케일 업(Scale-Up)

: 단일 서버 성능 강화 (CPU 클럭/코어 증가) - 스케일 아웃(Scale-Out)

: 여러 노드를 연결해 고속 네트워크로 확장 (클러스터 구조)

*클럭 (Clock)

: CPU가 명령을 처리하는 속도로, 단위는 GH/z(초당 수십억 번의 사이클)

: 클럭 속도가 높을수록 단일 스레드 성능이 좋아짐

*코어 (Core)

: CPU 내에서 독립적으로 연산을 수행하는 처리 장치

: 코어가 많을수록 병렬 작업(멀티스레딩)에 유리

*클러스터 (Cluster)

: 여러 대의 서버(노드)를 하나의 시스템처럼 묶어 작업을 병렬 처리하는 구조

: HPC, 빅데이터, AI 학습 환경에서 사용

🎯 HPC와 AI가 만나는 지점

AI도 대규모 데이터를 빠르게 처리해야하고, 복잡한 모델(수백~수천억 파라미터)을 학습하려면 HPC의 인프라가 필수입니다.

특히, AI 훈련 단계에서는 고성능, GPU, 대역폭이 넓은 네트워크, 초저지연 스토리지가 필요합니다.

HPC는 전통적으로 과학기술 계산, 제품 설계·테스트, 시뮬레이션, 디지털 미디어 등에서 사용되어 왔지만,

이제는 AI와 결합해 Surrogate 모델링 같은 새로운 영역을 만들어내고 있습니다.

*대역폭 (Bandwidth)

: 네트워크가 메모리가 단위 시간당 전송할 수 있는 데이터 양

: 단위 - Gbps(기가비트/초), GB/s(기가바이트/초)

*Surrogate (서로게이트)

: HPC·AI 맥락에서는 복잡하거나 계산량이 큰 원래 모델을 대신해, 더 단순하고 계산이 빠른 모델로 근사(simulation)를 수행하는 방법

🔄 상호 발전의 선순환 구조

- AI → HPC

AI가 생성한 데이터를 HPC 환경에서 분석·시뮬레이션해 제품 개발과 성능 개선에 활용 - HPC → AI

HPC 인프라로 대규모 AI 모델을 효율적으로 학습·배포

결국 두 기술은 서로의 성장을 가속시키며, 하나의 통합된 환경으로 발전하고 있습니다.

💬 "Azure는 HPC 하드웨어와 소프트웨어를 모두 갖춘, 유일한 풀스택 클라우드입니다."

🏆 세계 1위 민간용 슈퍼컴퓨터 ‘Eagle’

마이크로소프트는 HPC의 사용자이자 공급자입니다.

창립 50주년이 된 지금, Azure는 전 세계 500대 슈퍼컴퓨터 중 민간용 1위인 Eagle을 보유하고 있습니다.

정부 특수 목적 시스템을 제외하면, 클라우드에서 제공되는 최고 성능 HPC입니다.

이 성과는 단순한 스펙 경쟁이 아니라,

- 온프레미스와 동일한 아키텍처·환경 제공

- 사용자 이전 부담 최소화

라는 원칙을 10년 넘게 지켜온 결과입니다.

예를 들어, 영국 기상청은 기상 시뮬레이션 전부를 Azure에서 운영하며, 10년 장기 계약으로 안정성을 확보했습니다.

🔑 HPC·AI 인프라의 4대 핵심 요소

Azure는 HPC와 AI 인프라를 다음 4개 영역으로 나눠 최적화합니다.

- 컴퓨팅 – 고성능 CPU·GPU 아키텍처

- 스토리지 – 대역폭·확장성·비용 효율을 갖춘 저장소

- 네트워크 – 초저지연·고속 연결 (InfiniBand 지원)

- 통합 툴 – 하드웨어와 앱을 손쉽게 연결하는 소프트웨어

*Infiniband (인피니밴드)

: HPC 환경에서 널리 사용되는 초고속·저지연 네트워크 인터커넥트 기술

⚙️ 1. 컴퓨팅 – Azure HPC·AI VM 라인업

Azure의 HPC·AI 전용 가상머신(VM)은 크게 GPU 기반 N 시리즈와 CPU 기반 H 시리즈로 나뉩니다.

*VM (Virtual Machine, 가상 머신)

: 물리 서버 위에서 가상화 기술로 구현한 독립 실행 환경

: CPU·메모리·스토리지·네트워크를 가상으로 할당받아 독립적으로 OS 및 애플리케이션 실행 가능

🎯 N 시리즈 – GPU 중심

AI·그래픽·연산 등 다양한 GPU 워크로드에 대응하는 라인업입니다.

이름 규칙은 용도를 직관적으로 알 수 있게 설정되어 있습니다.

| 시리즈 | 의미 | 주요 용도 |

| ND | Deep Learning | 대규모 AI 학습·추론 |

| NC | Computing | 범용 연산 + AI 트레이닝·추론 |

| NV | Visualization | 그래픽 작업·CG·VDI 환경 |

*VDI (Virtual Desktop Infrastructure)

: 데이터센터나 클라우드에서 가상 데스크톱 환경을 제공하는 기술

: 사용자는 PC, 태블릿, Thin Client 등을 통해 원격으로 데스크톱 OS와 애플리케이션 사용 가능

💡 TIP

- 시리즈 구분은 ‘편의상’ 제안된 것이며, 실제 업무 목적에 따라 혼용 가능

- 모든 VM에 CPU + GPU + 대용량 메모리 탑재 → 다양한 작업에 활용 가능

🚀 H 시리즈 – CPU 중심

순수 연산 성능이 중요한 HPC 워크로드에 적합합니다.

특히 HB 시리즈는 ‘B = Bandwidth’라는 이름 그대로 메모리 대역폭 최적화가 특징입니다.

- 메모리 대역폭이 곧 성능

- GB/s → km/h로 비유하면 직관적으로 이해 가능

- HC: 191Gb/s ≈ 세단 속도

- HBv3: 350Gb/s ≈ KTX 속도

- HBv4: 초음속 제트기

- HBv5: 극초음속 로켓급

💡 TIP

- CPU 코어 수·메모리 용량보다 메모리 대역폭이 HPC 성능 결정 요인

- 업무 요구사항(데이터 크기·연산 패턴)에 따라 적합한 대역폭 선택 필요

📌 GPU 선택 기준

N 시리즈의 세부 스펙에서 GPU 메모리 용량은 용도를 가늠하는 좋은 지표입니다.

| GPU 메모리 | 적합 용도 |

| 대용량 | 대규모 모델 트레이닝, 복잡한 머신러닝 |

| 중·소용량 | 경량 추론, 그래픽 처리, VDI |

💡 TIP

- 트레이닝(Training), 추론(Inference), 그래픽 작업, VDI 등 목적 기반으로 선택

- 메모리 크기가 곧 처리 가능한 모델·데이터셋 크기를 결정

💾 2. 스토리지 – 유연성과 확장성이 핵심

HPC·AI 환경에서 스토리지는 성능·확장성·비용 효율성을 모두 고려해야 하는 핵심 요소입니다.

📍 온프레미스 vs 클라우드

| 구분 | 온프레미스 | Azure 클라우드 |

| 구성 | 고속 I/O용 스크래치 스토리지 + 대용량 아카이브 스토리지 |

다양한 계층형 스토리지 옵션 |

| 확장성 | 제한적 (3~5년 주기 교체) | 온디맨드 확장 가능 |

| 구성 변경 | 비용·시간 부담 큼 | 즉시 변경 가능 |

| 최적화 | 구축 시 고정 | 필요 시 언제든 조합 가능 |

*I/O (Input/Output)

: 데이터의 입출력

: HPC·스토리지·네트워크에서 I/O 성능은 초당 데이터 전송 속도(Throughput)와 지연(Latency)로 평가

*스크래치 스토리지 (Scratch Storage)

: 임시 데이터 저장을 위한 고속 스토리지

: HPC 작업 중 생성되는 중간 데이터나 캐시 데이터를 저장

💡 Point

온프레미스는 구축 이후 변경이 어려운 반면, 클라우드는 언제든 구성 변경·최적화 가능

→ 워크로드·비용·성능 조건에 맞춰 유연하게 대응

🏗 Azure 주요 스토리지 옵션

| 스토리지 종류 | 특징 | 주요 사용 사례 |

| Azure Blob | 범용 객체 스토리지, 최대 15Gbps | 대규모 데이터 저장, 분석 |

| Azure Managed Lustre | 페타바이트급 단일 파일시스템, 병렬 I/O 지원 | HPC 워크로드, 병목 없는 데이터 교환 |

| Azure Files Premium | 파일 기반 스토리지, Blob 수준 비용 | 일반 파일 공유, 중간 성능/비용 균형 |

| Azure NetApp Files | NFS 기반 고성능 NAS, 온프레미스 NAS 경험 그대로 | 고성능 파일 공유, 기존 NAS 마이그레이션 |

*NFS (Network File System)

: 네트워크를 통해 원격 스토리지를 마치 로컬 디렉토리처럼 접근할 수 있게 해주는 파일 공유 프로토콜

*Blob (Binary Large Object)

: 대규모 비정형 데이터를 저장하기 위한 클라우드 객체 스토리지 형태

: Azure Blob Storage - 무제한 확장, HTTP/HTTPS 기반 접근, 저비용 장기 저장 가능

*NAS (Network Attached Storage)

: 네트워크에 연결된 파일 서버

: NFS나 SMB 같은 표준 프로토콜을 사용해 여러 사용자가 파일 공유 가능

*Lustre

: HPC 환경에서 쓰이는 고성능 병렬 파일 시스템

: 대규모 클러스터에서 페타바이트급 데이터 처리와 초고속 I/O 지원

🔗 데이터 접근 방식

- HPC 환경에서 가장 많이 쓰이는 NFS 방식은 Azure 대부분의 스토리지가 지원

(Blob, NetApp Files 등) - 단, Managed Lustre는 Lustre 전용 클라이언트 설치 필요

→ Azure CycleCloud로 설치·구성 자동화 가능

📌 정리

Azure 스토리지는 HPC·AI 환경에서 요구되는 속도, 확장성, 접근성을 모두 충족합니다.

온프레미스의 하드웨어 제약 없이, 워크로드 변화에 따라 최적화 구성이 즉시 가능합니다.

🌐 3. 네트워크 – 클라우드 유일의 InfiniBand 지원

HPC·AI 환경에서 네트워크는 저지연·고대역폭이 필수입니다.

특히 클러스터 환경에서 노드 간 통신 속도가 전체 성능에 직결됩니다.

🏆 Azure만의 차별점

- 퍼블릭 클라우드 중 유일하게 InfiniBand 제공

- 기존 온프레미스 환경에서 사용하던 RDMA 프로토콜 그대로 사용 가능

→ 코드 변경·작업 스크립트 수정 불필요

💡 다른 클라우드로 이전 시 InfiniBand 미지원 → RDMA 기반 워크플로 재작성 필요 → 비용·시간·위험 증가

*RDMA (Remote Direct Memory Access)

: 네트워크를 통해 다른 컴퓨터의 메모리에 직접 접근하는 기술

: CPU·OS 개입 없이 메모리 간 전송 → 낮은 지연(Latency)과 높은 대역폭

🚀 성능 스펙

- 최대 NDR 400Gbps 지원

- 초저지연·고대역폭 네트워킹

*NDR (Next Data Rate)

: 최신 Infiniband 표준 중 하나로, 400Gbps급 전송 속도 지원

: 이전 세대 HDR(200Gbps) 대비 2배 대역폭

: 초대규모 HPC·AI 학습 클러스터에서 고속 데이터 교환 가능

📊 실제 효과 – Ansys Fluent 사례

- CFD(전산유체역학) 시뮬레이션에서 64 VM 이상 사용 시 거의 선형에 가까운 성능 확장성 확인

- 가능 요인:

- InfiniBand의 고속·저지연 특성

- RDMA 기반 효율적인 데이터 전송

- 클러스터 환경 최적화

📌 정리

InfiniBand 지원은 단순한 속도 향상 이상의 의미가 있습니다.

- 성능: 대규모 병렬 워크로드에서도 선형 확장

- 호환성: 온프레미스 코드·환경 그대로 클라우드로 이전 가능

- 유일성: Azure에서만 제공되는 HPC·AI 핵심 네트워킹 기술

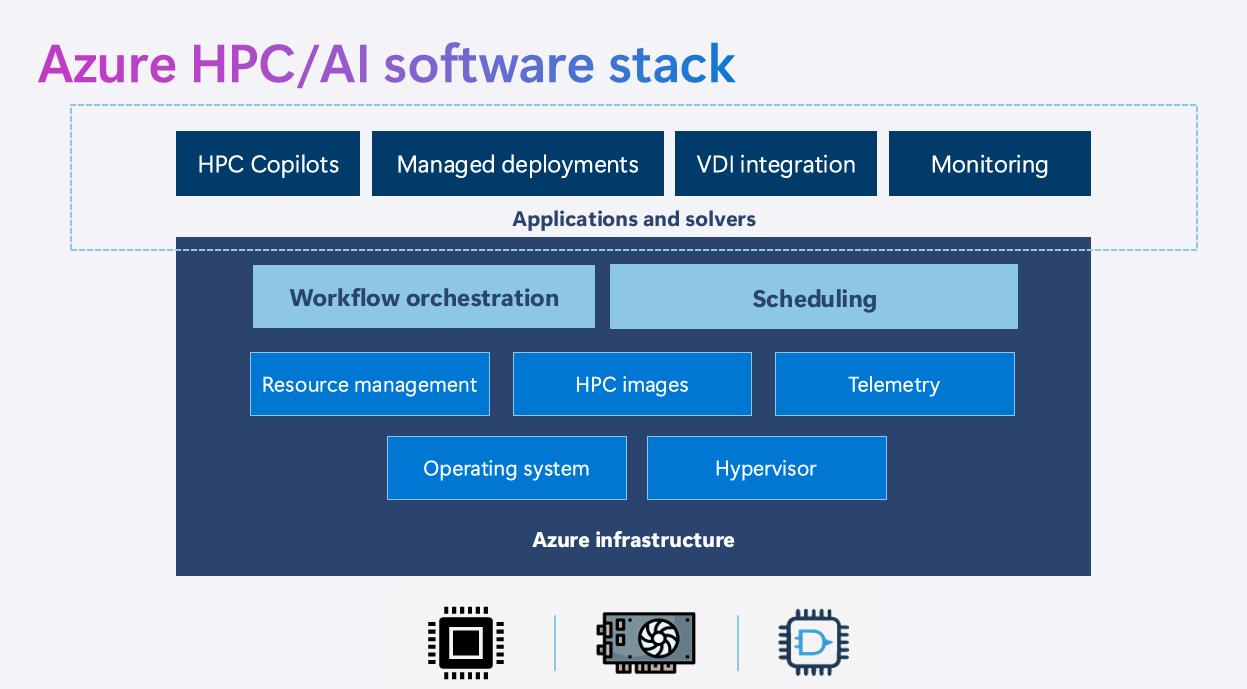

🛠 소프트웨어 – 하드웨어를 ‘즉시 실전 환경’으로

Azure는 HPC·AI 인프라를 단순히 제공하는 데서 그치지 않고,

온프레미스와 동일한 환경을 클라우드에서 더 빠르고 쉽게 구축·운영할 수 있도록 다양한 소프트웨어 도구를 제공합니다.

목표는 이전 지연 최소화와 운영 효율 극대화입니다.

📦 HPC 최적화 OS 이미지

- 문제: OS, 드라이버, 라이브러리, 개발도구를 직접 설치·최적화 시 며칠~수주 소요

- 해결책: Azure 마켓플레이스에서 Ubuntu HPC, Alma Linux HPC 이미지 제공

→ AI·HPC 필수 구성요소 사전 설치·테스트 완료

→ VM 생성 즉시 사용 가능, 환경 커스터마이징 불필요

*Ubuntu

: 리눅스 배포판 중 하나

: 서버·클라우드 환경에서 가장 많이 사용되는 오픈소스 OS

*Alma Linux

: RHEL(Red Hat Enterprise Linux)과 100% 호환되는 오픈소스 리눅스 배포판

: CentOS의 대안으로 개발

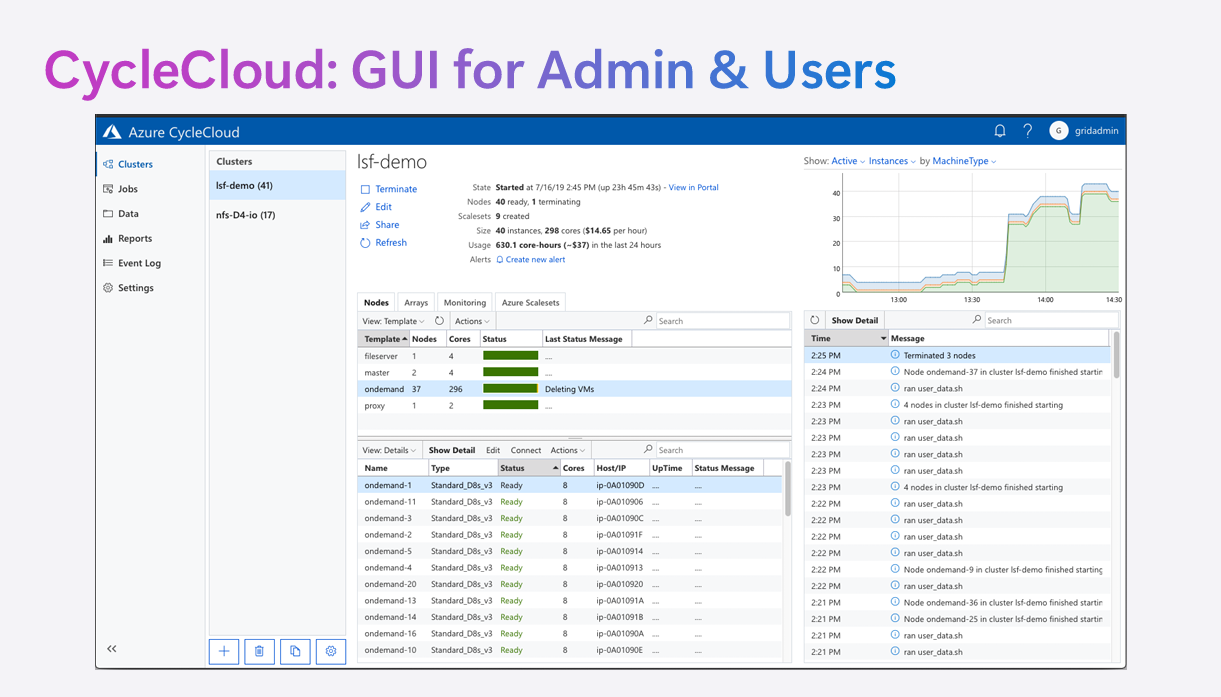

☁️ Azure CycleCloud – 클러스터 & 스케줄러 통합 관리

Azure CycleCloud는 온프레미스에서 사용하던 클러스터 매니저와 서드 파티 스케줄러(Slurm, LSF 등)를 변경 없이 Azure 환경에서 그대로 구현할 수 있는 솔루션입니다.

*서드 파티

: 특정 플랫폼·제품을 만든 회사가 아닌, 외부 개발자나 기업이 제공하는 소프트웨어나 서비스

*Slurm

: HPC 환경에서 가장 널리 사용되는 오픈소스 작업 스케줄러

: 대규모 클러스터에서 작업(Job) 관리, 리소스 할당, 큐 관리 수행

*LSF (Load Sharing Facility)

: IBM이 제공하는 상용 HPC 작업 스케줄러

: Slurm과 유사하지만 기업 환경에서 고급 기능과 지원 서비스 제공

- 클러스터 구성

- InfiniBand 지원 VM 기반의 고성능 클러스터 구성 가능 (Azure만 지원)

- 수십~수백 GPU 규모 클러스터도 1시간 이내 구축 가능

- 통합 관리 기능

- 클러스터 생성·최적화·모니터링·변경

- 작업 스케줄러 통합 관리 및 자동화

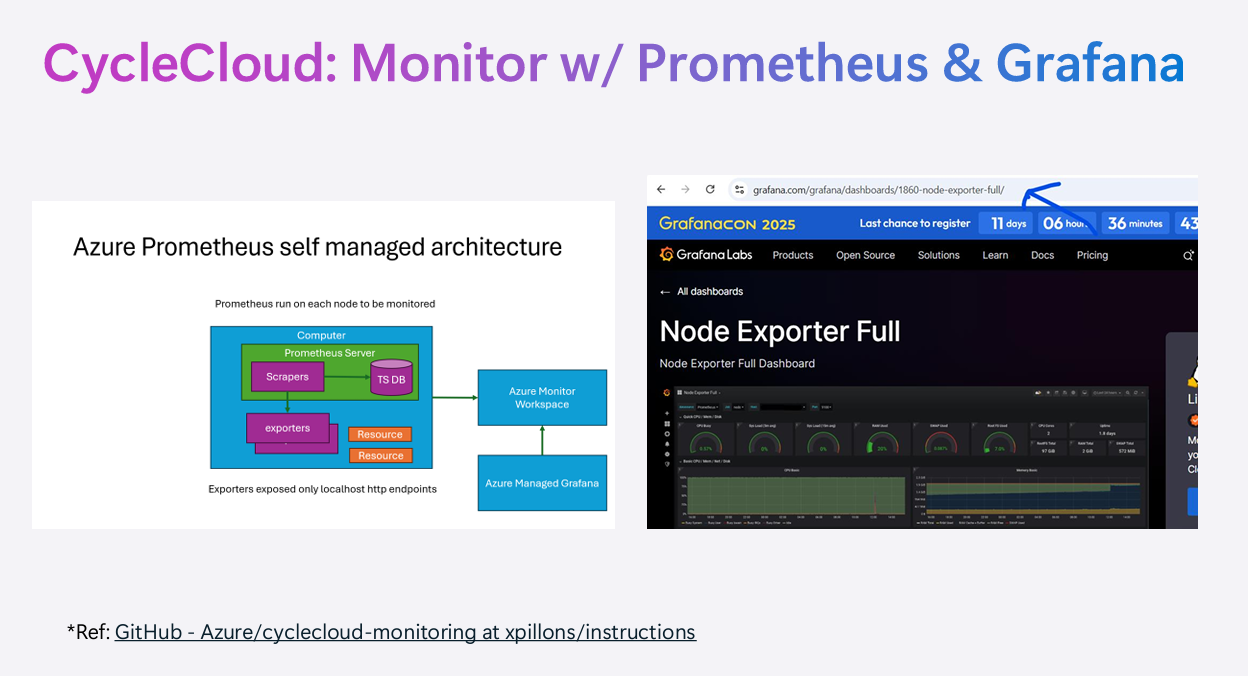

- 리소스 사용률·이벤트 모니터링 (Prometheus + Grafana 통합)

- GUI 기반 관리로 관리자·사용자 모두 직관적 사용 가능

*Prometheus

: 오픈소스 모니터링·알림 시스템

: 시계열(Time-series) 데이터 수집 및 분석에 최적화

*Grafana

: 시각화 도구로, Prometheus 등에서 수집한 데이터를 대시보드 형태로 시각화

- 배포 방식: 마켓플레이스의 CycleCloud VM 이미지로 바로 생성

- 장애 대응 자동화

- GUI에서 에러 클릭 → 원인 확인 → 버튼 한 번으로 Azure 포털 티켓 생성

- 로그·상태 자동 첨부, HPC 전담 엔지니어 즉시 대응

- 고숙련 어드민이 없어도 클릭 몇 번으로 장애 리포팅 가능

- 빠른 구축 사례

- 네트워크 구성 → CycleCloud VM 생성 → 템플릿 선택 → 클러스터 생성 → 작업 제출까지 45분

- 완전한 온프레미스 환경 동일 재현, 코드 변경 없이 즉시 작업 가능

- 수백 GPU 환경도 하루 내 이전 가능

- Slurm 전용 원클릭 배포

- CycleCloud Workspace for Slurm → VM·네트워크·스케줄러·패키지까지 자동 구성

- HPC/AI용 Slurm 클러스터를 최소 설정으로 즉시 운영 가능

🤖 Azure Batch – 클라우드 네이티브 배치 스케줄러

- 특징

- 작업 제출 → 배치 큐 적재 → 순차 실행

- 서드파티 스케줄러 불필요

- 작동 흐름

- 작업 명세서 작성

- 스크립트·입력 데이터 Azure Storage 업로드

- Batch가 풀(Pool) 생성·앱 설치

- 작업 실행 후 결과를 저장소 또는 로컬로 전달

- 적합 시나리오

- “작업만 제출하면 알아서 실행·결과 반환”

- HPC·ML 장시간 작업에 적합

- 100% 클라우드 환경에서 단순·자동화 지향

⚒️ HPC Pack – 올인원 HPC 관리 소프트웨어

- 무료 제공, 온프레미스·클라우드·하이브리드 모두 지원

- 클러스터 생성·관리·모니터링·리포팅·장애관리 통합

- Windows·Linux 모두 지원

- Azure 사용 시 오토 스케일링 가능 → 온디맨드 확장

*온디맨드 (On-Demand)

: 필요할 때 즉시 자원을 생성 및 할당하여 사용하는 방식

: 클라우드 VM, 스토리지, 네트워크 자원에 흔히 적용

- 예시

- PyTorch 이미지 분류 트레이닝

- HPC Pack GUI에서 실시간 상태·자원 사용량 확인

- 적합 시나리오

- 완전한 GUI 환경 필요

- 온프레미스와 클라우드 병행, DR·버스팅 환경 구축

*DR (Disaster Recovery)

: 데이터센터 장애나 재해 상황에서 서비스 지속성을 보장하기 위한 백업 및 복구 체계

*버스팅 (Cloud Bursting)

: 온프레미스 자원이 부족할 때 클라우드 자원을 임시로 확장하여 사용하는 방식

💡솔루션 선택 가이드

| 환경 | 추천 솔루션 | 이유 |

| 온프레미스 전용 | HPC Pack | 올인원 기능, 무상 제공 |

| 하이브리드 | HPC Pack | 온프레미스 ↔ 클라우드 연동, 버스팅 가능 |

| 클라우드 네이티브 | Azure Batch | 단순·자동화, SaaS 형태 |

| 기존 스케줄러 유지 | CycleCloud | 환경·코드 변경 없이 이전, InfiniBand 지원 |

Azure의 소프트웨어 스택은 하드웨어 성능을 즉시 실전 투입 가능한 환경으로 연결해줍니다.

온프레미스 대비 구축 시간은 수주 → 수시간으로 단축되고, 장애 대응·모니터링·확장까지 원클릭 자동화가 가능합니다.

📌 국내 고객 사례 – Azure HPC & AI 솔루션의 실제 효과

Azure의 HPC·AI 인프라와 소프트웨어 솔루션이 실제로 어떻게 적용되고, 고객들이 어떤 이점을 얻었는지 국내 사례를 중심으로 살펴봅니다.

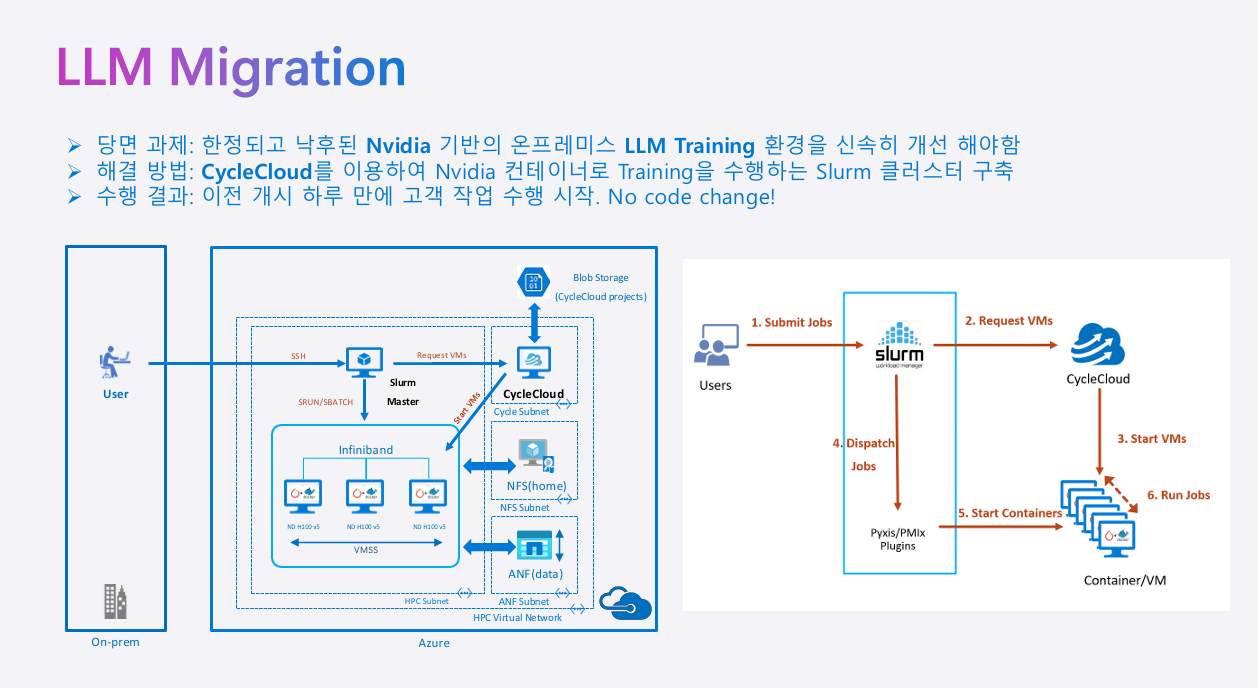

1️⃣ 대형 통신사 – LLM 환경의 신속한 이전

과제

- 기존 온프레미스 LLM 환경의 하드웨어 노후화

- 신규 GPU 도입 및 성능 확장 필요

- 환경 변경 없이 빠른 이전 요구

솔루션

- Azure CycleCloud + Slurm 스케줄러를 이용해 온프렘 환경을 그대로 Azure에 구현

- InfiniBand 지원 VM 기반 고속 네트워크 구성

- NVIDIA 머신러닝 컨테이너 자동 구성 (Enroot + PMIX 플러그인 통합)

*Enroot

: NVIDIA가 개발한 경량 컨테이너 런타임

: Docker 없이도 컨테이너 실행 가능

*PMIX (Process Management Interface for Exascale)

: HPC에서 분산 애플리케이션 간의 프로세스 관리와 통신을 표준화한 인터페이스

성과

- 하루 만에 코드 변경 없이 업무 이전 완료

- VM·컨테이너까지 자동 구성, 관리 부담 최소화

2️⃣ 바이오·헬스케어 – 유전체 데이터 분석 가속화

과제

- 유전체 데이터 서열 검색·비교 작업의 속도 향상 필요

- 연구자가 인프라 운영에 신경 쓰지 않고 연구에 집중할 수 있는 환경 필요

솔루션

- AI 에이전트 기반 문서·특허·논문 검색 자동화

- 염기서열 분석 도구(BLAST)의 AKS 기반 병렬 처리 지원

- HPC 작업을 AI 에이전트로 간단히 요청하면 백엔드에서 자동 처리

*AKS (Azure Kubernetes Service)

: Azure에서 제공하는 관리형 쿠버네티스 서비스

: 컨테이너 오케스트레이션, 자동 확장, 롤링 업데이트 등을 지원

성과

- 유전체 검색·비교·분석 속도 대폭 향상

- 연구자 중심의 간단한 인터페이스 제공

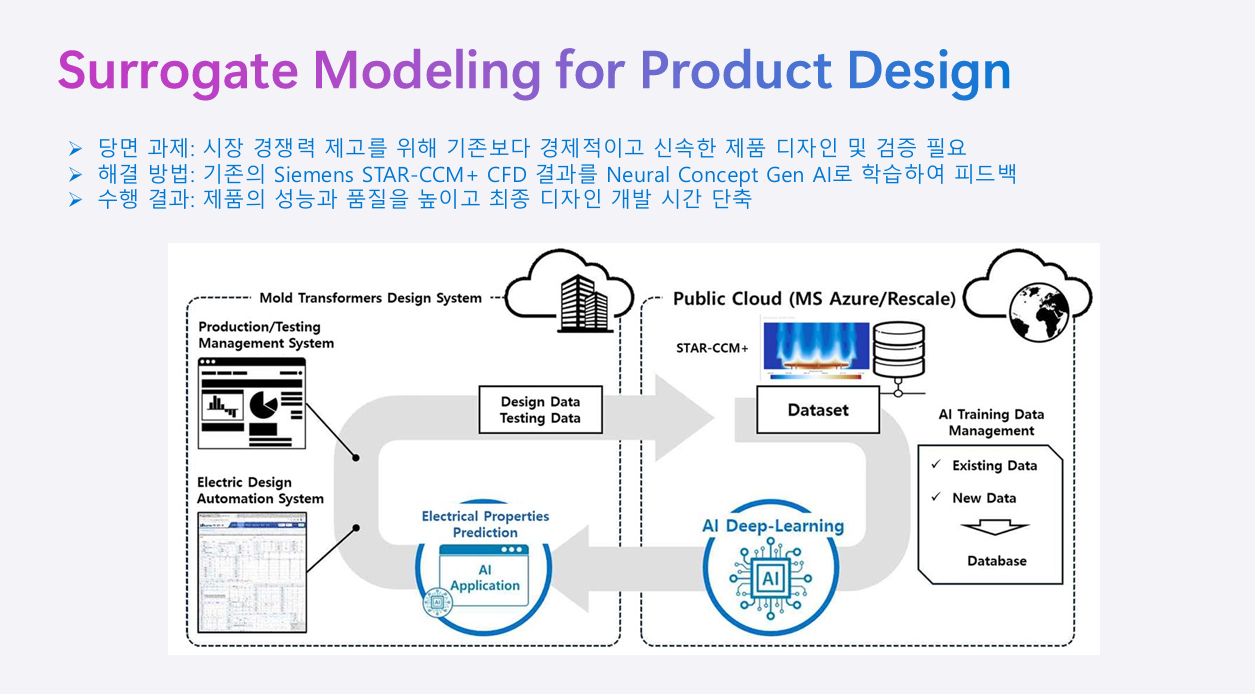

3️⃣ 제조·중공업·전자장비 – 시뮬레이션과 AI의 결합

과제

- 제품 디자인 검증(안정성·성능·효율) 시 많은 시뮬레이션 필요

- 개발 기간 단축 및 품질 향상 요구

솔루션

- Surrogate 모델링 기법 도입

- CAE 시뮬레이션 데이터 학습 → AI 피드백을 통한 디자인 개선

- HPC 인프라와 AI 모델의 상호 보완 구조 설계

*CAE (Computer-Aided Engineering)

: 컴퓨터를 활용해 제품 설계·분석·시뮬레이션을 지원하는 기술

성과

- 설계 정확도 향상

- 제품 개발 기간 단축

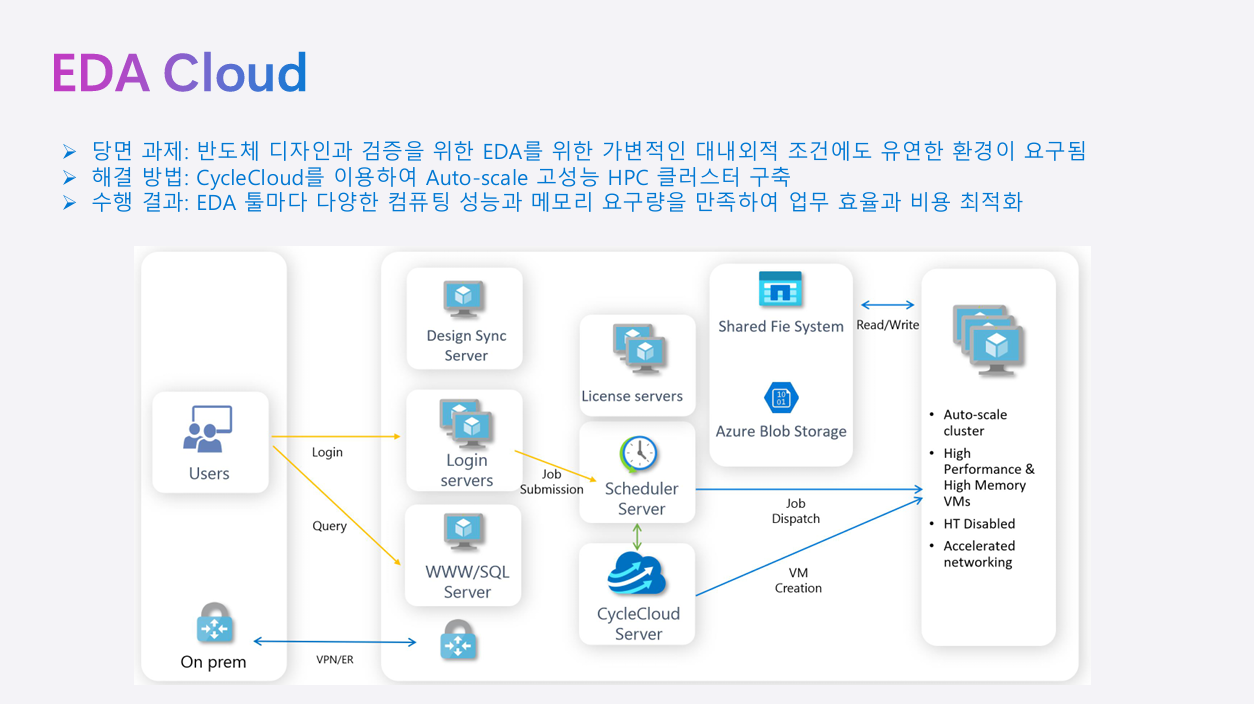

4️⃣ 반도체 설계·검증 – EDA 환경의 클라우드 전환

과제

- EDA 툴별 상이한 CPU·메모리·네트워크 요구사항

- 온프렘 환경에서의 변경·확장 어려움

솔루션

- Azure CycleCloud + 기존 스케줄러(Slurm, LSF)로 동일 환경 구현

- 온디맨드 오토 스케일링 클러스터로 필요 시 스펙 확장

- 다양한 VM SKU를 활용해 툴별 최적화 가능

*VM SKU

: 클라우드에서 VM의 사양·구성·성능을 구분하는 단위

성과

- 운영 유연성 확보 (온프렘 대비 즉각적인 환경 변경 가능)

- 최신 기술을 빠르게 반영

5️⃣ 금융권 – 고가용성 HPC 환경 구축

과제

- 상품 개발·위험 분석 환경에서 장애 시 업무 연속성 보장 필요

- 기존 DR(재해 복구) 대비 비용 절감 요구

솔루션

- HPC Pack 기반 멀티리전·멀티노드 클러스터링

- 온프렘-클라우드 하이브리드 환경 구성

- 장애 시 원격지(400km 이상) DR 전환 지원

성과

- 기존 DR 대비 50% 비용 절감

- 장애·버스팅 상황에도 안정적 연속성 보장

💡 Azure가 제공하는 HPC·AI 인프라는 50년간의 마이크로소프트 기술 투자와 최고 민간용 슈퍼컴퓨터·클라우드 유일 InfiniBand 지원 등 타사 대비 독보적인 경쟁력을 갖추고 있습니다.

온프레미스와 동일한 환경에서, 경우에 따라 하루 만에도 이전이 가능한 유연성과 속도, 그리고 무한 확장의 가능성은 Azure만이 줄 수 있는 장점입니다.

이렇게 해서 [2025 Microsoft Cloud & AI Bootcamp] 시리즈의 여정을 모두 마쳤습니다.

이번 편에서는 AI와 HPC의 긴밀한 관계, Azure가 제공하는 강력한 인프라와 솔루션, 그리고 실제 현장에서의 적용 사례를 함께 살펴봤습니다.

개인적으로 이번 부트캠프를 통해 단순히 ‘지식 습득’이 아니라,

실제 환경에서 활용 가능한 기술과 통합 솔루션의 가치를 직접 느낄 수 있었습니다.

특히, 부트캠프의 각 세션들을 수강하면서, 수강 중 제공하는 숨겨진 코드들을 모두 수집하여 플래티넘 등급 배지를 받았는데요! 🏅

부트캠프를 끝까지 듣고 적극적으로 참여하면 이렇게 멋진 성취의 증표도 받을 수 있습니다.

긴 시리즈를 함께 달려와 주신 모든 분들께 감사드리며,

앞으로도 AI와 클라우드 기술의 변화 속에서 계속 배우고, 실험하고, 나누는 여정을 이어가겠습니다.

여러분의 AI 여정, 우리 데이터스랩과 함께 시작해보세요! 😊

감사합니다. 뿅ㅇ_<☆

'Data & AI > Azure AI & MS Fabric' 카테고리의 다른 글

| AI Agent 왜 만들기만 하고 아무도 안 쓸까 (0) | 2026.02.10 |

|---|---|

| 데이터스랩(DatasRep), Microsoft 공식 파트너사로 합류!🎉 (1) | 2025.08.29 |

| [ 2025 Microsoft Cloud&AI 부트캠프 8편 ] 미래의 개발자를 위한 이야기 – 차세대 AI 개발자가 갖춰야 할 기술과 사고방식 (4) | 2025.08.01 |

| [ 2025 Microsoft Cloud&AI 부트캠프 7편 ] Cloud Native & AKS로 구축하는 글로벌 수준의 AI 플랫폼 전략 (2) | 2025.07.31 |

| [ 2025 Microsoft Cloud&AI 부트캠프 6편 ] AI로 개발을 가속하다 – 차세대 개발 도구와 플랫폼의 진화 (2) | 2025.07.30 |