개발자에게 AI는 더 이상 낯선 기술이 아닙니다.

하지만 "AI를 내 개발 환경에 어떻게 적용할 수 있을까?"라는 질문은 여전히 많은 사람들의 고민거리죠.

이번 [2025 Microsoft Cloud & AI 부트캠프] 7번째 이야기에서는

AI와 오픈소스, 그리고 개발을 가속하는 새로운 도구와 플랫폼이 실제 현업에서 어떻게 활용되는지를 자세히 다루었습니다.

📌

- 주제: Cloud Native & AKS로 구축하는 글로벌 수준의 AI 플랫폼 전략

- 일시: 2025년 7월 24일 목요일 오전 11:30 ~ 12:15

- 장소: 온라인

- 발표자: Brendan Burns ( Cloud Native 및 Management Platforms 부문 부사장, Azure )

🔗해당 세션 다시보기 링크🔗: AZBC: Cloud Native & AKS로 구축하는 글로벌 수준의 AI 플랫폼 전략

🔗모든 세션 다시보기 링크🔗: Microsoft Cloud and AI Bootcamp

"세상의 모든 앱이 AI로 재창조될 것"

이제는 누구나 자연스럽게 받아들이는 말이 되었지만, 이 말이 수년 전만 해도 혁신처럼 들리던 시절이 있었습니다.

하지만 현재는 AI가 단순한 기능 추가를 넘어서 애플리케이션 자체의 본질을 바꾸고 있습니다.

지금까지 불가능했던 방식의 문제 해결, 새로운 시장 창출, 인간 중심의 가치를 위한 AI 에이전트 도입 등은 바로 그 증거입니다.

💡 AI는 이제 일상의 동반자

- ChatGPT, 이미지 생성기, AI 코딩 도우미 등

- 그 또한 GitHub Copilot을 통해 새로운 프로그래밍 언어를 익혔고, 많은 이들이 시험 대비, 튜터링, 학습 도우미로 AI를 활용하고 있다고 말합니다.

- 이처럼 AI는 인간의 사고력과 창의력을 확장해주는 도구가 되었습니다.

그리고 중요한 사실 하나,

👉🏻 이 AI 기술의 대부분은 Azure 위에서 구동되고 있다는 점!

⚒️ Azure가 제공하는 기술 및 오픈소스

- Azure OpenAI, AI Studio, 모델 카탈로그. AI Search, Azure ML 등 완전한 AI 서비스 플랫폼 제공

- SaaS, PaaS뿐만 아니라 최신 GPU가 탑재된 IaaS까지 지원

- Hugging Face, Tensorflow, PyTorch 등 주요 오픈소스 생태계와도 밀접하게 연동

*SaaS (Software as a Service)

: 소프트웨어를 설치 없이 인터넷을 통해 제공받는 서비스

(예시) Gmail, Notion, ChatGPT

*PaaS (Platform as a Service)

: 개발자가 애플리케이션을 만들 수 있도록 플랫폼(인프라 + 툴)을 제공하는 서비스

(예시) Azure App Service, Google App Engine

* IaaS (Infrastructure as a Service)

: 서버, 스토리지, 네트워크 같은 인프라 자원을 가상으로 제공하는 서비스

(예시) AWS EC2, Azure VM

🌍 오픈소스 AI, 모두를 위한 기술

AI는 이제 특정 전문가들만의 기술이 아닙니다.

취미로 AI를 탐구하는 사람들, 학습 중인 학생들, 그리고 기업 규제에 맞춰 AI를 구현해야 하는 조직들까지,

모두가 AI에 접근할 수 있어야 합니다.

이처럼 오픈소스는 AI의 민주화를 가능하게 하는 핵심 도구입니다.

하지만 중요한 점은,

“대부분의 사람들은 AI 기술 자체보다는,

그 기술이 자신에게 어떤 가치를 줄 수 있는지에 더 관심이 있다”는 사실입니다.

AI를 효과적으로 활용하려면 단순히 GitHub에서 코드를 복사해 실행하는 것만으로는 부족합니다.

데이터 보안, 사용자 보호, 콘텐츠 통제 등 실무에서는 더 많은 고려가 필요합니다.

바로 이런 이유로, 오픈소스 생태계를 깊이 이해하고 있는 전문가와 함께하는 것이 중요합니다.

AI는 하드웨어, 소프트웨어, 컴퓨팅 환경까지 매우 빠르고 복잡한 속도로 발전하고 있습니다.

그렇기에 시작하려는 사람들에게는 이런 생각이 들 수 있습니다.

“AI를 어디서부터, 어떻게 시작해야 할까?”

Brendan Burns는 그 해답으로 이렇게 말합니다.

“오픈소스 AI는, 오픈소스를 기반으로 하는 플랫폼 위에서 실행되어야 한다.”

즉, 다양한 기술들을 모듈화된 방식으로 쉽게 가져다 쓸 수 있고,

복잡한 기술을 모든 사람이 접근 가능한 환경으로 바꾸어주는 인프라가 필요하다는 뜻입니다.

🧩 AI 인프라의 핵심, Azure Kubernetes 서비스(AKS)

AI는 단일 머신이 아닌 대규모 분산 환경에서 작동해야 하는 기술입니다.

이때 중요한 역할을 하는 것이 바로 Kubernetes입니다.

Azure는 오픈소스 AI와 Kubernetes를 결합한 Azure Kubernetes 서비스(AKS)를 통해

개발자들이 쉽게, 그리고 안정적으로 AI를 실행할 수 있도록 돕고 있습니다.

🔗 왜 Kubernetes인가?

- Kubernetes는 대규모 머신 리소스를 묶어서 관리할 수 있는 오픈 플랫폼입니다.

- 대형 학습 작업 중 문제가 생겨도 중단 없이 재시작이 가능하며,

- GPU/CPU 리소스를 자동 최적화하고, 무중단 롤링 배포도 지원합니다.

즉, 실험과 반복이 잦은 AI 개발 환경에서 사용자 경험을 해치지 않고도 지속적인 업그레이드가 가능한 구조입니다.

🌍 오픈 생태계에서 함께 성장하는 AI

Kubernetes는 Azure뿐만 아니라 전 세계 플랫폼에서 사용되며,

오픈 환경에서의 협업을 가능하게 합니다.

- 최신 NVIDIA 드라이버 설치

- 개별 드라이버나 SKU에 대한 복잡성을 추상화

- 프로비저닝, 구성, GPU 워크로드 관리까지도 자동으로 처리

이를 통해 대규모 학습이나 소규모 추론 작업을 비즈니스 요구에 맞춰 빠르게 시작할 수 있습니다.

*SKU (Stock Keeping Unit)

: 제품이나 서비스의 세부 단위를 구분하기 위한 코드

: 클라우드에서는 VM 사양, 가격, 지역 등 세부 설정을 나타냄

*프로비저닝 (Provisioning)

: 필요한 리소스(서버, 네트워크, 데이터베이스 등)를 사전에 설정하고 배포하는 과정

🚀 수요에 따라 자동 확장되는 인프라

AI 애플리케이션은 예기치 못한 트래픽 급증에 직면할 수 있습니다.

이를 대비해 Azure는 Karpenter, KEDA와 같은

이벤트 기반 자동 확장 도구를 제공합니다.

- KEDA (Kubernetes Event Driven Autoscaler)는 GPU 메트릭 기반으로 확장 가능

- 단순 CPU/메모리 기준이 아니라 실제 워크로드에 따라 확장

- GPU 활용률이 높아질 때 자동으로 리소스를 추가하여 안정성 확보

이 모든 작업은 Azure에서 자동화 및 모니터링되며,

개발자는 운영 부담 없이 AI 서비스를 확장할 수 있습니다.

*GPU 메트릭

: GPU의 사용률, 메모리, 온도 등 성능 지표

: AI 모델 학습/추론 시 모니터링에 필수

🧠 오픈소스 정신 그대로, KEDA는 CNCF에 기부

Azure는 KEDA를 단독 소유하지 않습니다.

- 오픈소스 코어 철학에 따라 CNCF에 기부

- 누구든지 자유롭게 가져다 쓰고, 원하는 플랫폼에서 실행 가능

- 전 세계 커뮤니티가 함께 참여 가능

즉, 단지 도구를 제공하는 것이 아니라

전 세계 개발자들의 경험과 노하우가 함께 반영된 생태계를 제공하는 것입니다.

*CNCF (Cloud Native Computing Foundation)

: 클라우드 네이티브 기술을 표준화하고 확산하는 오픈소스 재단

: Kubernetes도 여기 소속

💡 Multi-Instance GPU (MIG)

Multi-Instance GPU는 커뮤니티 차원의 혁신이 꼭 필요한 분야라는 것을 보여주는 예시입니다.

이를 사용하면, 하나의 GPU를 하드웨어 수준에서 분리된 개별 보안 GPU 인스턴스로 분할할 수 있습니다.

이것은 GPU를 효율적으로 분할해 활용하는 데 매우 중요한 기능입니다.

하지만 동시에, 이를 실현하기 위해서는 상위 Kubernetes 서비스의 구조도 변경되어야 했습니다.

- Kubernetes 커뮤니티의 다양한 분들과 함께 이 과제에 도전

- NVIDIA와 협력해 하드웨어를 개발

- Kubernetes에 통합

그 결과, GPU를 워크로드에 맞게 자유롭게 구성하고, 이 소중한 자원을 최대한 효율적으로 사용할 수 있게 되었습니다.

그리고 이 모든것은 Azure 뿐만 아니라 이 기능을 지원하는 NVIDIA GPU가 있는 어디에서든 사용 가능합니다.

🧱 하드웨어만큼이나 중요한 프레임워크

AI를 실제로 수행하려고 할 때, 하드웨어를 세팅하고 구성하는 것이 정말 중요한 작업이지만,

학습이나 추론을 쉽게 실행할 수 있도록 최고의 프레임워크를 제공할 수 있어야 합니다.

그런 관점에서, Kubernetes 위에 존재하는 AKS 인프라 위에 구축된 오픈소스 ML 생태계를 적극적으로 활용하고 있습니다.

PyTorch와 같은 도구나, Ray와 같은 플랫폼을 보면 알 수 있듯이,

이들은 AI 워크로드 실행을 지원하기 위해 오픈 환경에서 설계된 목적 지향적 플랫폼입니다.

이러한 오픈 기술들과의 결합을 통해,

AKS는 단순한 클러스터 서비스가 아닌 완성형 AI 인프라 플랫폼으로 진화하고 있습니다.

그럼 실제로 현업 개발 환경에서 AI는 어떻게 활용되고 있을까요?

🔍 반복되는 PR 리뷰, AI가 대신한다

주니어 개발자들의 PR(Pull Request)은

- 코드 스타일

- 함수 설계 방식

- 팀 코드 규칙 등

반복적인 리뷰가 필요합니다.

기존에는 이 역할을 시니어 엔지니어가 담당했지만,

설계나 API 구조 같은 고수준 의사결정에 집중하지 못하는 한계가 있었습니다.

이제는 생성형 AI 기반 PR 에이전트가 그 역할을 대신합니다.

PR이 생성되거나 수정되면,

→ GitHub Action이 작동

→ Kaito에 요청 전송

→ AI가 자동으로 리뷰 코멘트를 작성하는 흐름입니다.

🧠 Kaito, 개발자의 시행착오를 줄이는 AI 오퍼레이터

현업에서 AI를 적용하려 할 때 가장 먼저 마주하는 질문은 다음과 같습니다:

- “어떤 모델을 써야 하지?”

- “어떤 GPU를 선택해야 하나?”

- “서비스는 어떻게 구성하고 테스트하지?”

추론마다 성능이 다르고, 작업마다 적절한 모델과 리소스가 달라지기 때문에

이 질문에 대한 정답을 찾는 건 개발자에게 매우 큰 부담이 됩니다.

바로 이 지점에서 등장하는 것이 Kaito (Kubernetes AI Toolchain Operator)입니다.

🤖 복잡한 AI 실행 환경, 한 줄 선언으로

Kaito는 AI 추론 및 튜닝 작업에 필요한 모든 요소를 자동화해줍니다.

✅ 적절한 GPU 선택

✅ 여러 GPU로 작업 분산

✅ RESTful API 구성

✅ 메모리/성능 문제 사전 방지

✅ YAML 기반 워크플로우 자동 구성

즉, 사용자는 "프롬프트 → 응답"이라는 추론 개념만 이해하면 됩니다.

그 외의 복잡한 배포, 자원 관리, 스케일링 등은 Kaito가 모두 처리해줍니다.

*RESTful API

: 웹에서 데이터를 주고받기 위한 설계 방식

: URL과 HTTP 메서드(GET, POST 등)를 활용해 간결하고 일관된 API를 만듦

*YAML (YAML Ain’t Markup Language)

: 사람이 읽기 쉬운 데이터 포맷

: 인프라 설정, GitHub Actions, Kubernetes 등에서 널리 사용됨

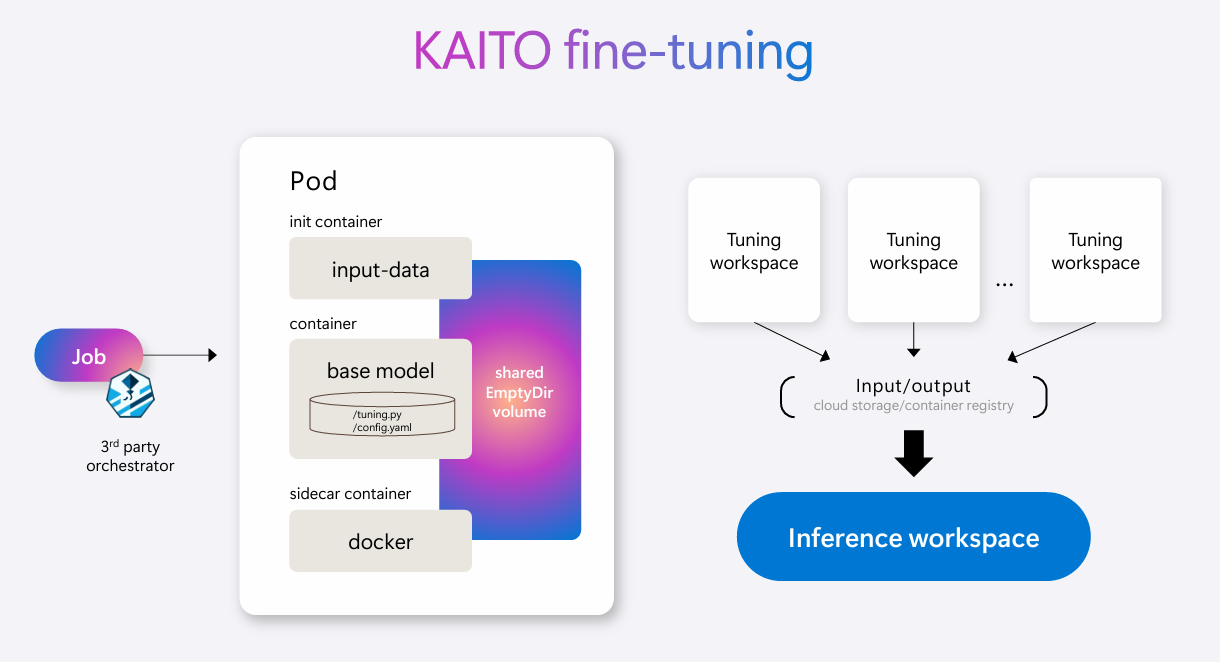

🔧 파인튜닝도 선언만 하면 끝

기성 모델(LLaMA 2, Phi-3 등)을 내 코드베이스나 도메인에 맞게 적응시키고 싶을 때,

파인튜닝은 강력한 도구입니다.

Kaito에서의 파인튜닝은 다음과 같이 간단하게 이루어집니다:

- 레이블링된 데이터와 베이스 모델 지정

- Kaito가 이를 컨테이너로 패키징

- 자동으로 튜닝 작업 공간 구성

- 컨테이너 레지스트리를 통해 입출력 관리

- 결과 모델은 기존 모델과 동일한 추론 방식으로 바로 사용 가능

💡 중요한 점:

기존 모델에서 파인튜닝 모델로 전환하더라도

→ 엔드포인트나 워크플로우 설정은 전혀 변경할 필요가 없습니다.

*컨테이너 레지스트리 (Container Registry)

: Docker 이미지 같은 컨테이너 파일을 저장하고 배포하는 저장소

(예시) Docker Hub, Azure Container Registry

*엔드포인트 (Endpoint)

: 클라이언트가 API나 모델, 서비스에 접근하기 위한 고유 주소(URL)

🔁 DevOps처럼 반복 가능한 ‘지속적 튜닝’

이제 많은 팀들이 파인튜닝을 넘어서

지속적 튜닝(Continuous Tuning)이라는 개념으로 확장하고 있습니다.

마치 CI/CD처럼,

데이터 수집 → 분석 → 재튜닝 → 추론 반영 → 사용자 피드백 → 반복

이 루프가 자동으로 돌아가는 구조입니다.

지표 예시: 사용자 만족도 / 응답 정확도 / 유지율 등

이 모든 흐름도 Kaito가 자동 처리합니다.

사용자는 단지 “지속적 튜닝”의 개념만 이해하면 되고, 복잡한 파이프라인 구성은 필요 없습니다.

GitHub Actions와 유사한 방식으로,

AI 모델의 지속적 배포(Continuous Delivery)를 선언형으로 운영할 수 있게 되는 것입니다.

🔍 RAG: 개인화와 프라이버시를 동시에 만족시키는 AI

Kaito는 이제 RAG(Retrieval-Augmented Generation) 기능도 통합했습니다.

이는 개인화된 AI 응답을 제공하면서도 데이터 프라이버시를 지킬 수 있는 매우 강력한 방식입니다.

✔️ RAG가 필요한 상황 예시

- 📁 사내 소스코드를 바탕으로 코드 생성 → 하지만 소스코드는 비공개

- 📄 문서 기반 응답 생성 → 모델 학습은 불가능하지만, 개인화는 필요

기존 모델에 직접 학습시키지 않아도,

검색된 정보를 프롬프트에 덧붙여 응답을 생성하는 방식이 바로 RAG입니다.

예시:

“오늘 약속 몇 시였지?” → 내 일정은 학습되지 않았지만,

내 메시지 기록을 검색해 응답 생성 가능

🧠 Kaito + RAG = 설정은 더 쉽고, 결과는 더 정교하게

RAG는 일반적으로 벡터 DB 구성, 인덱싱, 검색 설정 등

구축 난이도가 높은 기능이지만,

Kaito에서는 선언형 구성 한 줄로 실행할 수 있습니다.

Kaito의 최신 버전에서는:

- 벡터 DB 자동 포함

- 동음이의어(예: deer vs dear) 구분

- 문서 검색 + 프롬프트 통합 자동화

덕분에 개발자는 RAG 기능을 실험에서 프로덕션까지 단축된 시간 내에 구현할 수 있습니다.

Kaito는 GitHub에 공개된 오픈소스 프로젝트이며,

AKS(Azure Kubernetes Service)에서 사용하면 공식 지원도 받을 수 있습니다.

📊 GPU 모니터링까지 자동으로: 관찰 가능성이 곧 경쟁력

AI 모델을 프로덕션에 배포한 이후, 가장 중요한 질문은 이것입니다:

“이 모델이 정말 잘 작동하고 있나?”

- 사용자는 “속도가 느리다”고 느끼고,

- 팀은 “최신 GPU로 바꾸면 나아질까?”를 고민합니다.

하지만 어떤 지점에서 성능이 향상되고,

어떤 지점에서는 병목이 발생할 수 있습니다.

단순한 업그레이드가 항상 정답이 아닐 수도 있습니다.

🔧 Azure가 제공하는 GPU 관찰 인프라

Azure는 다음을 통해 GPU 관측 자동화 인프라를 제공합니다.

| 구성 요소 | 역할 |

| NVIDIA GPU Operator | GPU 메트릭 수집 |

| Azure 관리형 Grafana | 대시보드 구성 및 시각화 |

| 오픈 대시보드 템플릿 | GPU 병목 및 활용 상태 빠르게 파악 가능 |

Grafana는 오픈소스 시각화 도구로,

- 전문가가 만든 템플릿

- 다중 GPU 모니터링

- 병목 탐지 차트 등

복잡한 지식 없이도 강력한 모니터링을 가능하게 합니다.

🤖 Microsoft Copilot in Azure: AI 여정의 진짜 출발점

Azure는 자사 내부에서도 AI를 적극 활용하고 있습니다.

이른바 “도그푸딩(dogfooding)” 문화죠.

최근 공개된 Azure용 Microsoft Copilot은

채팅 기반 인터페이스로 AI + 클라우드를 통합적으로 다룰 수 있게 도와줍니다.

💬 Copilot은 어떤 질문에 답할 수 있나요?

- “Kubernetes에서 Kaito를 어떻게 배포하죠?”

- “현재 내 리소스 구성은 적절한가요?”

- “GPU 사용량이 급등했는데, 이유가 뭘까요?”

- “YAML 설정 예시 보여줘”

- “지금 내 환경에서 가장 저렴한 실행 방식은?”

이 모든 질문에 Copilot이 AI 기반으로 응답합니다.

*도그푸딩 문화 (Dogfooding)

: 자사에서 만든 제품을 내부 직원들이 먼저 사용해보는 문화

: 실제 사용자 관점에서 품질을 검증할 수 있음

✅ 정리: Azure + Kaito + Copilot, AI 운영의 완성형 조합

| 기능 | 제공 도구 |

| RAG + 개인화 | Kaito + VectorDB |

| 추론/튜닝 자동화 | Kaito |

| GPU 모니터링 | GPU Operator + Grafana |

| 대화형 인터페이스 | Azure Copilot |

| 오픈소스 기반 확장 | GitHub + AKS 공식 지원 |

🧪 실전 데모: VS Code에서 시작해 ChainLit까지

이제는 말뿐이 아니라, 실제로 LLM을 배포하고 사용하는 전체 흐름을 살펴볼 시간입니다.

마이크로소프트는 데모를 통해 Kaito Workspaces가 Visual Studio Code + Azure Kubernetes Service(AKS) 상에서 어떻게 작동하는지를 보여주었습니다.

🧭 데모 흐름 요약

- Kubernetes 확장 설치

VS Code에서 Azure Kubernetes 클러스터 확인 가능 - Kaito 설치 및 모델 배포

- Microsoft가 개발한 Phi 모델 선택

- YAML 설정 자동 생성

- 배포 후 Web UI에서 프롬프트 테스트 가능

- 실시간 상호작용

- 예: "쿠버네티스란 무엇인가요?"

- 출력 확인, 파라미터 수정, 모델 삭제까지 Web에서 가능

이처럼 몇 번의 클릭과 짧은 코드만으로 모델을 배포하고 테스트까지 완료할 수 있는 경험은

"AI를 실험단계에서 실제 서비스로 옮기는 속도"를 획기적으로 줄여줍니다.

🔗 ChainLit으로 확장된 AI 앱 개발

실험을 넘어 이제는 애플리케이션 수준의 확장입니다.

여기서 마이크로소프트는 오픈 커뮤니티 프로젝트인 ChainLit을 활용해

Kaito로 배포한 LLM을 채팅 인터페이스 기반 앱으로 구현하는 예를 보여주었습니다.

구현 흐름

- Python 가상환경에서 UV 툴로 앱 실행

- 초기 Kaito 프롬프트와 동일한 환경을 ChainLit에 통합

- 결과: 시각적 인터페이스를 갖춘 채팅형 앱 완성

이 구조는 단순한 API 테스트를 넘어서,

프로덕션 환경에 배포할 수 있을 만큼의 완성도를 보여줍니다.

🔚 AI 혁신의 핵심은 "열린 생태계"

이번 세션은 단순한 기술 소개를 넘어서

"오픈소스가 AI 혁신의 진정한 동력"임을 강조했습니다.

- Microsoft는 자신들이 만든 기술뿐 아니라,

오픈 커뮤니티에서 일어나는 혁신을 함께 수용합니다. - Kaito는 Azure 관리형 환경 위에서 시작할 수 있으며,

필요시 ChainLit, LangChain, HuggingFace 등 다른 오픈소스 프로젝트와 유기적으로 통합됩니다.

결국, 쿠버네티스부터 LLM, 앱 프레임워크까지

AI를 실험이 아닌 실전으로 옮기는 길은 생각보다 가까이 있습니다.

그리고 그 길은 Azure에서 더욱 빠르고 안전하게 열려 있습니다.

AI와 개발이 만나는 지점,

이제는 실험이 아닌 실행의 시대입니다.

여러분의 AI 여정,

우리 데이터스랩과 함께 시작해보세요! 😊

다음 주제는 미래의 개발자를 위한 이야기 – 차세대 AI 개발자가 갖춰야 할 기술과 사고방식 입니다.

다음 글에서 뵙겠습니다!

감사합니다. 뿅ㅇ_<☆

※ 본 글은 Microsoft Cloud & AI Bootcamp 세션을 기반으로 작성되었으며, 정리 과정에서 OpenAI ChatGPT를 활용하여 작성하였습니다.